本内容按照吴恩达公开课《Machine Learning》的 Lecture Slides 进行分类,每一个H1标题对应一个Lecture Slide,每一个H2标题对应Lecture Slide中的一个小章节。

本内容是课程的简化总结,适合已经了解机器学习基本概念的人进行回顾以及查漏补缺。

# 8 神经网络: 表征

# 8.1 非线性假设

讲了图像分类的例子,图像里的像素点作为输入,如果做多项式特征(特征两两相乘),那么特征数量会非常非常多(假设50x50共2500个像素点,那么做多项式特征后会变成约300万个特征)。

# 8.2 神经元与大脑

神经网络起源于尝试用算法模拟大脑。

神经网络曾在80和90年代非常流行,90年代过后热度下降,最近又重新复活。

科学家发现人脑的区域具有学习功能,给与新的电信号刺激,它可以学习这个电信号的功能,例如:

# 8.3 模型表示 I

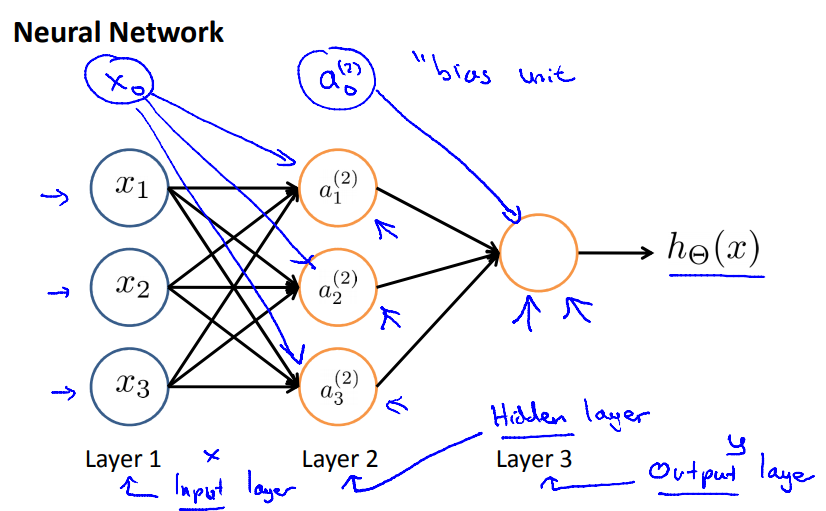

模型可以表示为有向图,图的顶点用来表示中间变量/函数变换,图的边用来表示数据流

其中参数一般并不会显式地在图上表达出来,一般来讲一条边就对应有一个参数,例如

# 8.4 模型表示 II

前向传递:通过输入x和参数计算输出估计值

# 8.5 例子和直观理解 I

Ng简单讲了一下用一层神经网络表示来分别拟合 y = x1 AND x2 和 y = x1 OR x2 的例子

# 8.6 例子和直观解释 II

讲了一下用1层隐藏层的神经网络来拟合 y = x1 XNOR x2 的例子,通过增加层数就能很好地拟合一些较为复杂的函数了

举了手写数字识别的例子,LeNet 5,通过增加神经网络的层数和复杂度(CNN)就能够获得图像识别上取得较好的效果

# 8.7 神经网络多分类

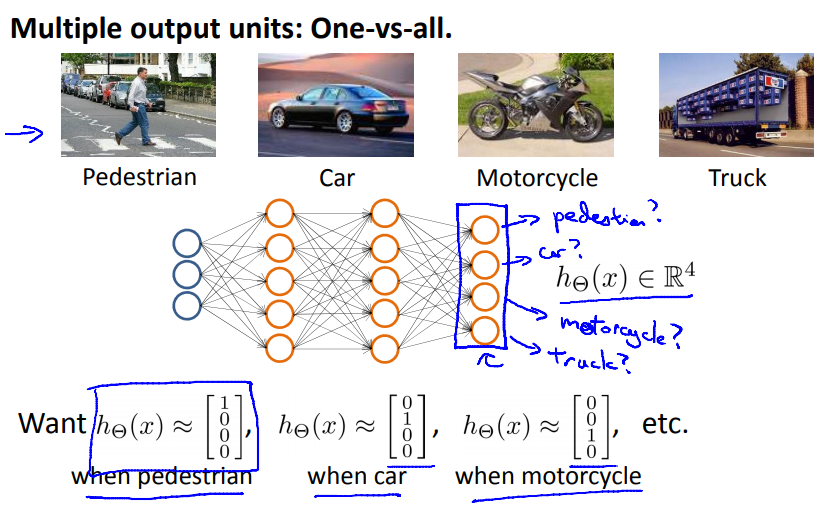

与之前的逻辑回归一样,也是一对多(one-vs-all),但是,通过神经网络,可以用直接用一张图表示出来:

在最后一层,孤立每个不同的输出神经元,其实相当于是训练了多个模型。

← 7.正则化 9.神经网络: 学习 →