本内容按照吴恩达公开课《Machine Learning》的 Lecture Slides 进行分类,每一个H1标题对应一个Lecture Slide,每一个H2标题对应Lecture Slide中的一个小章节。

本内容是课程的简化总结,适合已经了解机器学习基本概念的人进行回顾以及查漏补缺。

# 2 一元线性回归

# 2.1 模型介绍

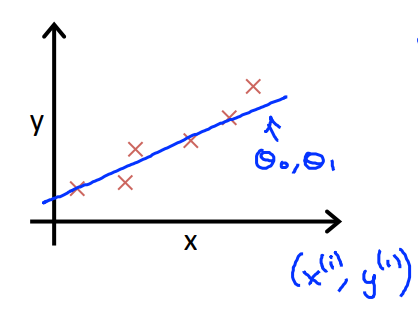

以房价预测举例,x为房屋面积,y为房价,那么通过训练数据来学习到的模型

# 2.2 损失函数

如何学习正确的

# 2.3 损失函数理解 I

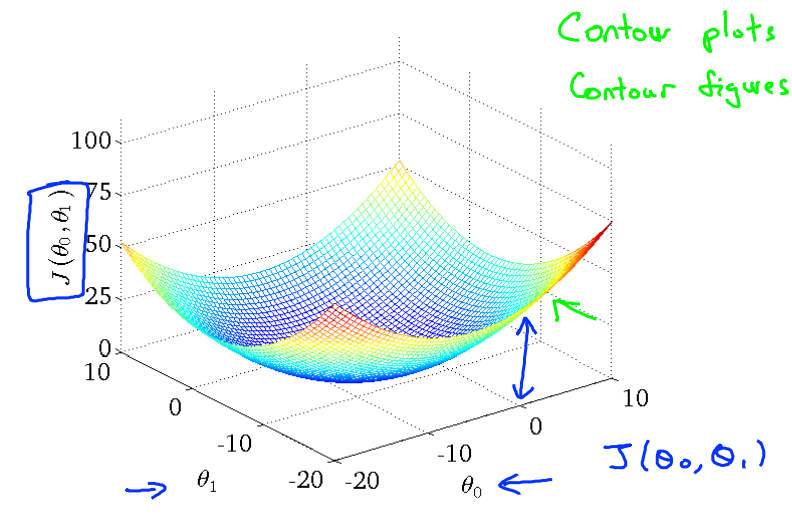

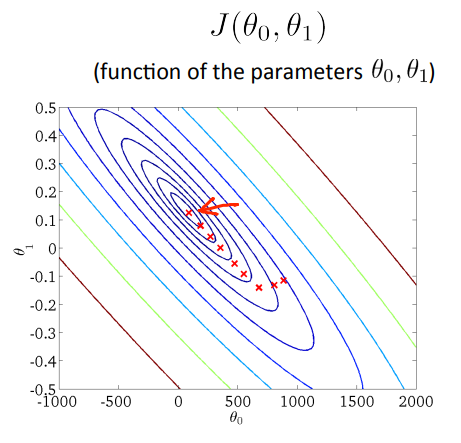

损失函数的目的是最小化均方误差:

# 2.4 损失函数理解 II

模型:

参数:

损失函数:

目标:通过改变

编者注:后来我们知道,最小化损失函数的过程就是一个凸优化问题

# 2.5 梯度下降

重复下面步骤,直到收敛:

重点:一定要一次性计算好所有方向上的梯度,然后一次性更新所有

参数。以下步骤是错误的:

(此举会导致参数按每个梯度方向都更新一次)

# 2.6 线性回归的梯度下降

求导可得:

批梯度下降:对应损失函数中的m,批梯度下降使用所有的训练数据

随机梯度下降:一次训练不采用全部的训练数据(降低m),目的是减少计算量